当大语言模型遇上机器人,研究人员正在开发可以完成复杂推理任务的各种机器人

最近几个月以来,越来越多的项目开始使用大语言模型来创建机器人应用程序,这在以前几乎是很少见的。由于大语言模型和多模态模型的强大功能,研究人员正在创造能够处理自然语言命令并完成需要复杂推理任务的机器人。

人们对大语言模型和机器人技术交叉领域日益增长的兴趣也重新恢复了机器人创业社区的活跃程度,也有几家相关的创新公司获得了巨额融资,并发布了令人印象深刻的演示产品。随着大语言模型的技术进步逐渐渗透到现实世界中,我们可能会看到机器人技术的一个新时代。

创建机器人系统的传统经典方法需要复杂的工程来创建规划和推理模块。创建与机器人交互的界面也很困难,因为人们可以用许多不同的方式发出相同的指令。随着大语言模型和视觉语言模型(vision language models)的出现,机器人专家能够以前所未有的方式增强现有的机器人系统。朝着这个方向迈出的第一步是谷歌研究院(Google Research)的SayCan项目。SayCan项目使用大语言模型中编码的语义知识来帮助机器人对任务进行推理,并确定哪些动作序列可以帮助完成任务。

人工智能和机器人研究科学家Chris Paxton向媒体表示,从系统的角度来看,SayCan的一个优点是它非常模块化。它可以让你把不同的部分组合在一起,构建一个可以做很酷的演示系统,会非常吸引人。

在SayCan项目之后,其他研究人员开始探索语言和视觉模型在机器人中的应用,已经能够在不同的方向上取得进展。一些机器人项目使用通用大语言模型和视觉语言模型来开发机器人应用程序,而另一些项目则尝试为机器人任务开发定制模型。Chris Paxton表示,我们已经看到,使用大语言模型和大视觉模型使感知和推理等事情变得更容易实现。这使得许多机器人在执行任务方面看起来比以前更可行。

经典的机器人系统的一大限制是如何对它们进行控制。机器人开发团队可以训练机器人的技能,比如开门和拉抽屉,或者挑选和操纵某个物体。然而,训练机器人结合这些技能来完成更加复杂的任务是很困难的。这就是为什么它们通常显得非常死板,需要明确的指示来执行复杂的任务。

视觉语言模型和大语言模型可以使机器人将松散定义的指令映射到机器人技能范围内的特定任务序列。有趣的是,许多模型可以在不需要训练的情况下完成这些任务。Chris Paxton表示,我可以利用这些不同的技能,通过这些型语言模型,我可以把它们串在一起,然后推理我应该如何使用它们。有了像GPT-4V这样的视觉语言模型,我们可以看到这些系统如何整合在一起,并在广泛的应用场景中发挥作用。

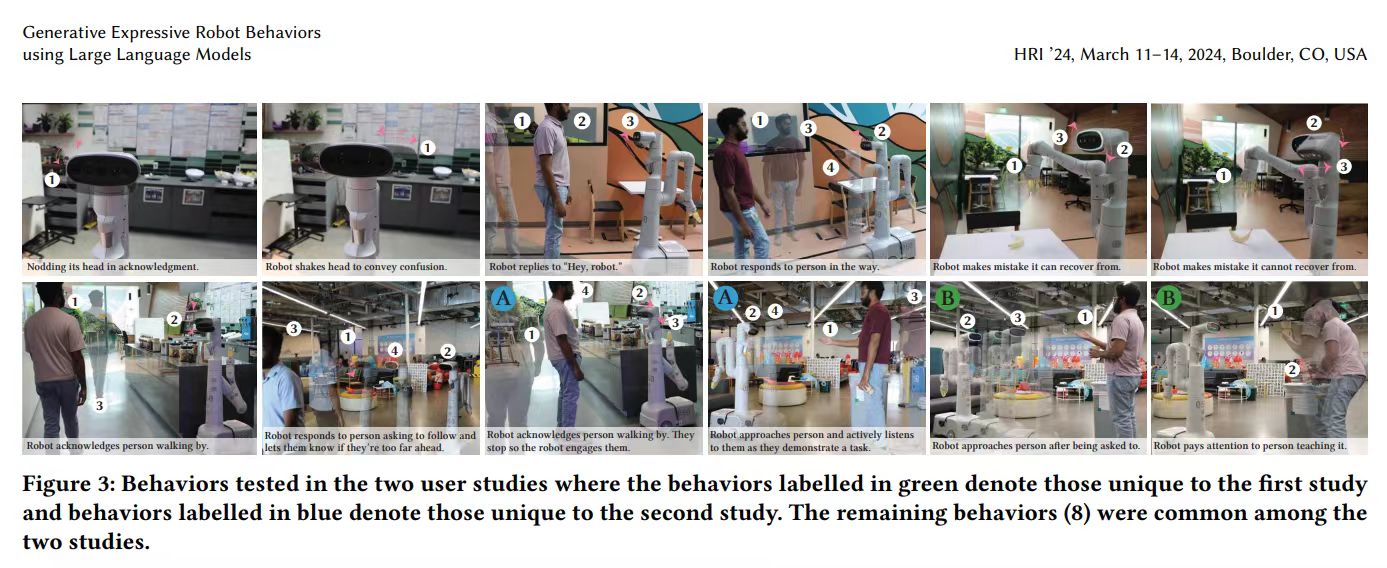

一个案例是GenEM,这是一项由多伦多大学、Google DeepMind和Hoku实验室联合开发的技术。GenEM使用大语言模型中可用的大量社会背景来为机器人创建表达行为。GenEM使用GPT-4对环境进行推理,并根据机器人的表现来决定它应该采取什么样的行为。例如,大语言模型认为,向人们点头是一种礼貌的行为。然后,它将其转换为机器人支持的特定动作,例如上下移动头部。它利用其训练数据中包含的大量知识以及上下文学习能力来实现这一目标,这使它能够将动作映射到机器人的API调用。

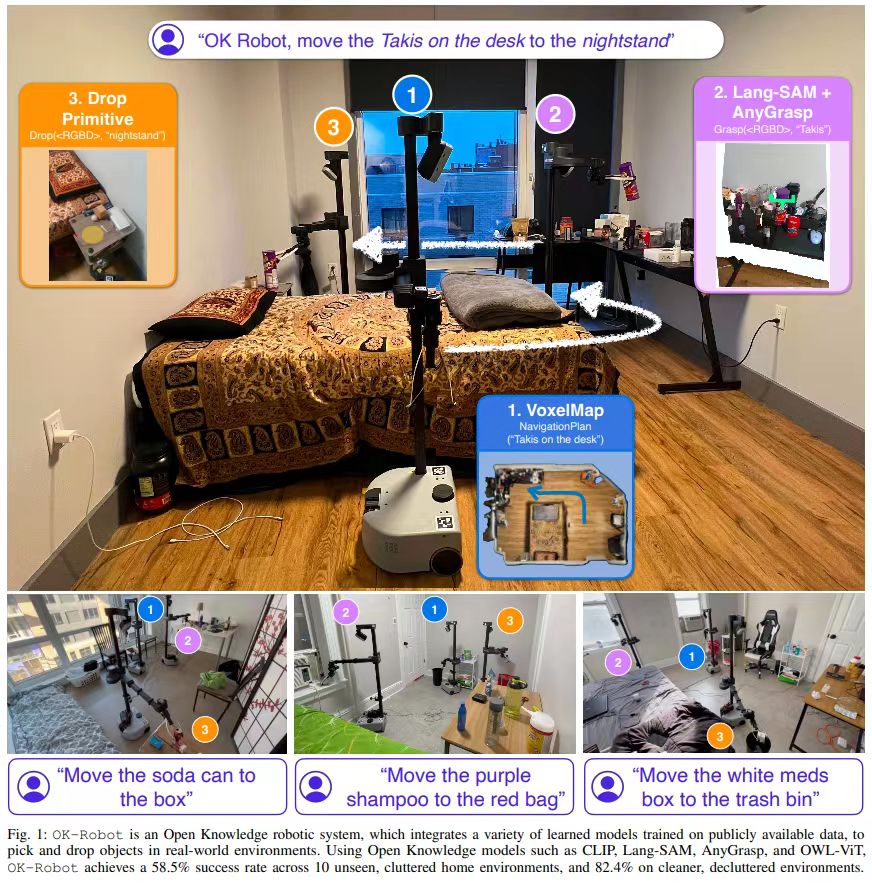

另一个项目是OK-Robot,这是一个由Meta和纽约大学共同开发的系统,它将视觉语言模型与运动规划和对象操作模块结合起来,在机器人从未见过的环境中执行拾取和丢弃操作。

随着语言模型的能力不断增强,一些机器人初创公司也在获得新的成功。例如,总部位于加州的机器人初创公司Figure最近融资了6.75亿美元,用于制造由视觉和语言模型驱动的人形(类人)机器人,这家公司的机器人使用OpenAI的模型来分析指令并计划行动。

然而,值得注意的是,虽然大语言模型和视觉语言模型解决了重要的问题,但这些机器人开发团队仍然必须为基本技能(如抓取和移动物体、避开障碍物和环境导航)创建系统。

Chris Paxton表示,还有很多其他的工作是在这些模型无法处理的水平下进行的。这是很难做到的事情。在很多方面,这是因为数据不存在。这就是所有这些公司都在做的东西。

使用大语言模型和视觉语言模型的另一种方法是为机器人开发专门的基础模型。这些模型通常建立在预训练模型中包含的大量知识的基础上,并根据机器人的动作定制它们的架构。

在这方面最重要的项目之一是谷歌公司(Google)的RT-2,这是一种视觉语言动作(VLA)模型,它将感知数据和语言指令作为输入,并直接向机器人输出动作命令。Google DeepMind最近开发了RT-X-2,这是RT-2的高级版本,可以适应不同类型的机器人形态,并可以执行未包含在训练数据中的任务。而DeepMind和斯坦福大学(Stanford University)合作的RT-Sketch则可以将粗略的草图转化为机器人的行动计划。

Chris Paxton表示,这是另一个令人兴奋的方向,它是基于端到端学习的,你把摄像头用作输入,机器人就会找出它需要做的大部分事情。

机器人的基础模型也已经进入了商业领域。今年3月份,Covariant公司发布了RFM-1,这是一个估值80亿美元的参数转换器(parameter transformer model)模型,通过文本、图像、视频、机器人动作和一系列数值传感器读数进行训练。Covariant公司旨在为不同类型的机器人创建一个可以解决许多任务的基础模型。

另外,英伟达公司在Nvidia GTC大会上发布的Project GR00T也是一个通用的基础模型,它使人形机器人能够将文本、语音、视频甚至现场演示作为输入,并对其进行处理,以采取特定的后续行动。

语言模型仍然有很多未开发的潜力,并将继续帮助机器人研究人员取得进展。随着大语言模型的不断进步,我们可以期待他们的研究成果将引领机器人技术的创新。

延伸阅读:

- 前亚马逊公司高管创办,主打非人形协作机器人的Cobot获1亿美元B轮融资

- 麻省理工学院发布新研究,将大语言模型和家用机器人集成以使其能自主适应外部环境的变化

- 海外媒体报道,亚马逊产业基金将加大对结合AI和机器人的创新项目的投资

- 人工智能人形机器人公司1X融资1亿美元,曾获OpenAI投资

- 加州大学伯克利分校发布多功能控制系统,利用生成式AI让人形机器人更好地适应未知环境

Powered by Froala Editor