英伟达发布Nemotron-4 340B的开源模型系列,为开发者提供用于训练大语言模型的合成数据

近日,据英伟达公司(NVIDIA)官网介绍,其推出了名为Nemotron-4 340B的开源模型系列,该模型系列将使开发者用于生成合成数据(synthetic data),这些合成数据可以用于训练大语言模型,并用于医疗保健、金融、制造业、零售和其他所有行业的商业应用。

众所周知,高质量的训练数据在自定义大语言模型的性能、准确性和响应质量中起着至关重要的作用,但高质量的数据集可能非常昂贵且难以获取。通过特定的开源模型许可,Nemotron-4 340B为开发者提供了一种免费的、可扩展的方式来生成合成数据,这些数据可以帮助构建大语言模型。

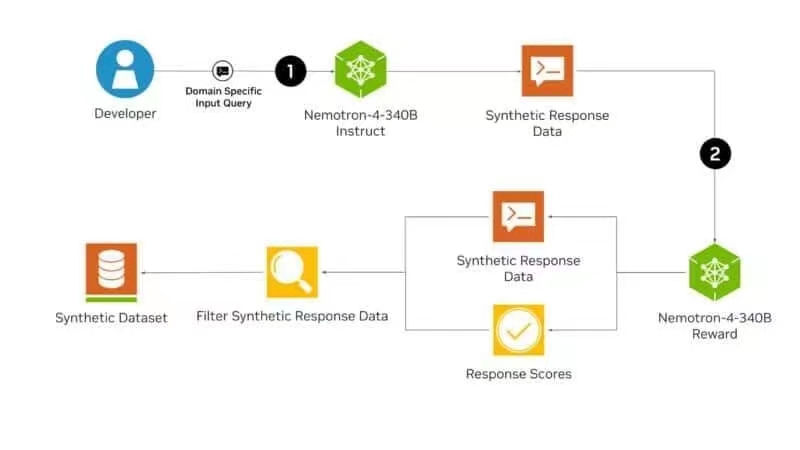

Nemotron-4 340B模型系列包括了基础(basic models)、指令模型(instruct models)和奖励模型(reward models),形成一个管道生成用于训练和精炼大语言模型的合成数据。这些模型经过优化,可以与NVIDIA NeMo(一个用于端到端模型训练的开源框架)协同工作,包括数据管理、定制和评估。它们还针对开源NVIDIA TensorRT-LLM库进行了推理优化。

目前,Nemotron-4 340B可以在Hugging Face上进行下载,开发者也将很快就可以在ai.nvidia.com上访问这些模型,这些模型将被打包成一个NVIDIA NIM微服务(microservice),并带有一个标准的应用程序编程接口,该接口可以部署在任何地方。

大语言模型可以帮助开发者在访问大型、多样化的标记数据集有限的情况下生成合成训练数据。Nemotron-4 340B的指令模型(instruct models)创建了模拟真实数据特征的各种合成数据,有助于提高数据质量,从而提高各个领域定制大语言模型的性能和鲁棒性。

然后,为了提高人工智能生成数据的质量,开发者可以使用Nemotron-4 340B的奖励模型(reward models)来过滤高质量的响应。Nemotron-4 340B的奖励模型对五个属性的回答进行评分:有用性、正确性、连贯性、复杂性和冗长性。

在合成数据生成管道中,(1)首先使用Nemotron-4 340B的指令模型生成基于文本的合成输出。(2)Nemotron-4 340B的奖励模型评估生成的文本,提供指导迭代改进的反馈,并确保合成数据准确、相关并与特定需求保持一致。

研究人员还可以使用他们的专有数据,结合所包含的HelpSteer2数据集,定制Nemotron-4 340B的基础模型,从而创建他们自己的指令或奖励模型。

通过使用开源的NVIDIA NeMo和NVIDIA TensorRT-LLM,开发者可以优化他们的指导和奖励模型的效率,以生成合成数据并对响应进行评分。

所有Nemotron-4 340B模型都使用TensorRT-LLM进行了优化,以利用张量并行性(tensor parallelism),这是一种模型并行性(model parallelism),其中单个权重矩阵在多个GPU和服务器上分割,从而实现大规模的高效推理。

Nemotron-4 340B的基础模型(base models)经过9万亿个token的训练,可以使用NeMo框架进行定制,以适应特定的用例或领域。这种微调过程受益于广泛的预训练数据,并为特定的下游任务产生更准确的输出。

NeMo框架提供了多种定制方法,包括监督微调和参数高效微调方法,如低秩自适应(LoRA)。

为了提高模型质量,开发者可以将他们的模型与NeMo Aligner和Nemotron-4 340B奖励模型(reward models)注释的数据集对齐。校准是训练大语言模型的关键步骤,其中模型的行为使用诸如人类反馈强化学习(RLHF)等算法进行微调,以确保其输出安全、准确、适合上下文并与预期目标一致。

寻求企业级支持和生产环境安全性的企业也可以通过云原生NVIDIA AI企业软件平台访问NeMo和TensorRT-LLM,该平台为生成式AI基础模型提供加速和高效的运行时间。

Nemotron-4 340B指令模型进行了广泛的安全性评估,包括对抗性测试,并在广泛的风险指标上表现良好。用户仍然应该仔细评估模型的输出,以确保合成生成的数据适合、安全和准确地用于他们的用例。

延伸阅读:

- 英伟达首席执行黄仁勋称,大概有2万家各类生成式AI创新公司在使用英伟达的计算平台

- 英伟达旗下投资部门参与投资,英国的AI语音客户服务公司PolyAI获4600万欧元C轮融资

- 软银、英伟达和微软联合投资,自动驾驶技术公司Wayve融资10.5亿美元

- 英伟达发布通用人形机器人基础多模态模型Project GR00T

- 英伟达发布可以在本地运行的AI聊天机器人,更加注重数据安全和个人隐私

Powered by Froala Editor