OpenAI发布最新AI模型GPT-4o,响应速度更快和支持端到端的多模态输入输出,会对教育科技产品有哪些新潜力

5月13日,人工智能公司OpenAI在其春季发布会上发布了最新的人工智能模型GPT-4o(o是Omni的缩写),该模型可以在移动端和桌面端都可以使用。根据OpenAI的说法和演示,GPT-4o给出回复的速度比之前的版本更快,并改进了文本、视频和音频功能。GPT-4o可以接收和推理文本、音频和视觉的任何组合作为输入,然后通过自然语言和自然的声音,并且可以以文本、音频和图像的任何组合进行输出。

据OpenAI官网介绍,GPT-4o对音频输入的回复响应时间达到了232毫秒,平均为320毫秒,这与人类对话中的响应时间非常相似。OpenAI表示,GPT-4o在英文文本和编码上的性能和GPT-4 Turbo相当,在非英语文本上的表现性能也有显著改善。并且GPT-4o也将提供API,速度会比之前的模型更快,价格降低了50%。与现有模型相比,GPT-4o在视觉和音频理解方面尤其出色。

在GPT-4o之前,用户使用语音模式(Voice Mode)和ChatGPT对话时,平均延迟为2.8秒(GPT-3.5)和5.4秒(GPT-4)。之所以如此,是因为语音模式(Voice Mode)主要由3个独立的模型组成:一个模型将音频转录为文本,第二个是通过GPT-3.5或GPT-4接收文本并输出文本,第三个模型则将文本转换回音频作为输出。这个过程意味着会丢失大量信息,GPT-4不能直接观察输入者的音调、多个说话者或背景噪音,也不能输出笑声、歌声或表达情感等情绪。

而到了GPT-4o,OpenAI训练了一个跨越文本、音频和视频的端到端模型,这意味着所有输入和输出都是由同一个神经网络进行处理,所以它的响应速度也要比之前的版本高出不少。

OpenAI首席技术官Mira Murati表示,随着模型变得越来越复杂,我们希望人机交互的体验变得更加自然,这是我们第一次真正在易用性方面向前迈出一大步。OpenAI的前沿研究主管Mark Chen表示,有了新的实时对话语音功能,你可以打断模型,而不必等待回应,模型就会捕捉到你的情绪。

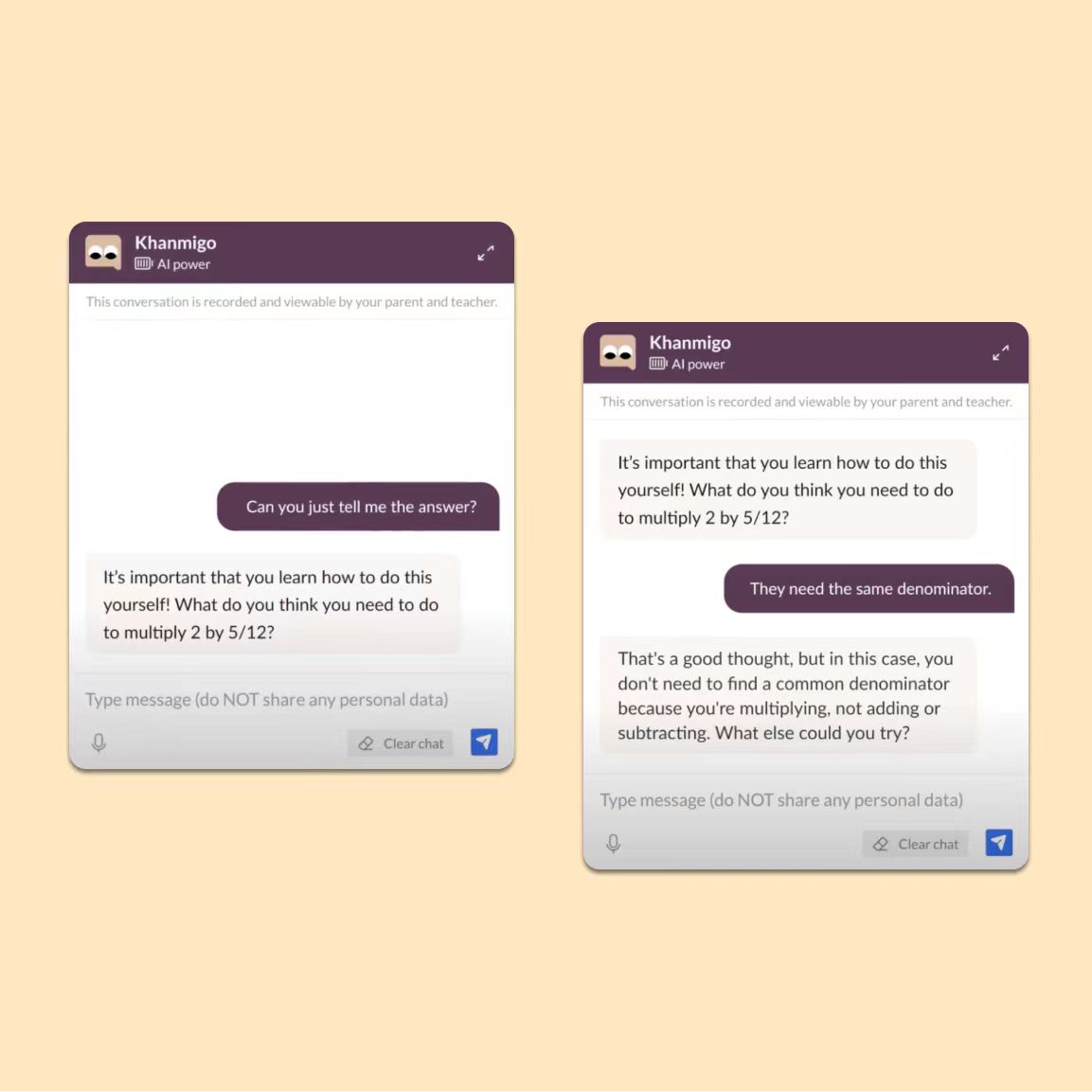

人们和ChatGPT的交互还包括了直接使用视频方式,用户可以分享遇到的数学问题的实时画面,并寻求ChatGPT进行帮助,ChatGPT会帮助你自己解决问题。在一段演示视频中,演示者使用GPT-4o与ChatGPT分享了他们的屏幕,ChatGPT帮助学生一步一步地解决了一个数学问题。与一次提供解题答案不同,ChatGPT能够引导学生找到解题方案。学生还可以使用手机摄像头分享他们的笔记本,ChatGPT也能够理解笔记本中的内容。

让我们想象下GPT-4o可能对教育科技产品的影响:

根据OpenAI的现场演示,GPT-4o能够识别对话者的语气和情绪,甚至可以根据对话者的要求做出语气的调整。我们之前曾报道过一家名叫Mightier的将视频游戏用于儿童的情绪管理的应用。

Mightier为孩子提供了一系列的视频游戏,并且这些视频游戏可以和一个可穿戴的心率监测器相结合,这能够让孩子们练习如何让情绪保持平静,在遇到沮丧的时候保持心平气和。据介绍,这套系统适用于容易焦虑、发脾气或愤怒的孩子,但也适用于那些被诊断为注意力缺陷多动障碍(ADHD)、对立违抗性障碍(ODD)和自闭症障碍(ASD)的孩子。试想一下,借助GPT-4o的情绪识别能力,是否能够在和孩子的交流互动中识别孩子们的情绪并做出正确对应的语气反馈呢?

可汗学院是最早接入OpenAI的GPT-4模型的教育科技公司之一,并发布了自己的AI学习和教学助手Khanmigo。OpenAI此次也演示了在教育场景中的应用可能,也展示了通用人工智能模型在影响教育产品设计中的潜在影响。人们可以想象或许很快会有一个更懂学生、更理解学生、更像真人教师的AI老师的出现,它们无论是在反馈速度、反馈语气、反馈质量等都将有极大的提高。

综合性看,此次发布的GPT-4o的突出能力更加侧重于交互方面,并且试图创建一个易于使用的交互界面,也提供文本、音频和视频的交互模式,这对于OpenAI的用户规模和粘性是有很大帮助的。我们可以设想在教育学习场景中如何利用GPT-4o的这些最新能力,或许很快会有一些新产品出现,“交互”(人机交互和人人交互)是教育学习中的重要场景。

延伸阅读:

- 与OpenAI合作,亚利桑那州立大学探索生成式AI在教学和学术研究中的潜力

- OpenAI与非营利性组织Common Sense Media合作,将指导青少年和家庭如何正确地使用人工智能

- 亚利桑那州立大学成为OpenAI在高等教育领域的首个合作伙伴,将探索AI在学术研究和行政效率中的价值

- OpenAI与德国媒体巨头Axel Springer合作,将为ChatGPT用户提供内容服务

- OpenAI发布面向教师的如何在课堂上使用ChatGPT的官方指南

及时了解最新的全球教育科技投资,请关注我们的Edtracker栏目(知识星球),查阅全球教育科技周报和月报。关于Edtracker,可以查阅我们之前的介绍(点击这里)。

Powered by Froala Editor